Chronologically Consistent Generative AI

创建于 更新于

摘要

本报告介绍了一系列具有严格时间戳限制的指令式大语言模型(ChronoGPT-Instruct),旨在消除训练中的先见偏差,实现训练数据与预测任务时间的完全时序隔离。通过多阶段数据精筛和验证,确保模型无未来信息泄漏,同时保留一定的预测能力。以金融新闻为例,构建基于模型输出的交易组合回测,证明至少有54%的预测能力在无泄漏情况下仍然存在,为研究者提供了衡量大语言模型免泄漏预测能力的基准工具 [page::0][page::2][page::13][page::15][page::17]

速读内容

研究背景与问题提出 [page::0][page::1]

- 大规模语言模型(LLM)广泛应用于金融预测,但普遍存在训练泄漏导致的先见偏差问题。

- 现有研究多采取局部遮蔽或预训练时间截断,难以完全消除未来信息渗透。

- 报告提出ChronoGPT-Instruct模型,训练严格限定时间截点,实现完全时序隔离。

数据与方法 [page::3][page::6][page::7]

- 采取分阶段训练:预训练数据和指令微调数据均限制在截止知识日期前。

- 使用基于GPT-4.1的提示过滤算法筛选微调对话数据,确保无后期知识内容。

- 指令微调数据超42.5万条,来源分三个阶段,数据集设计兼顾认知复杂度和对话长度。

- 金融市场分析用的是2007-2023年多年的道琼斯新闻头条结合CRSP股票回报数据。

指令跟随模型评估 [page::9][page::10]

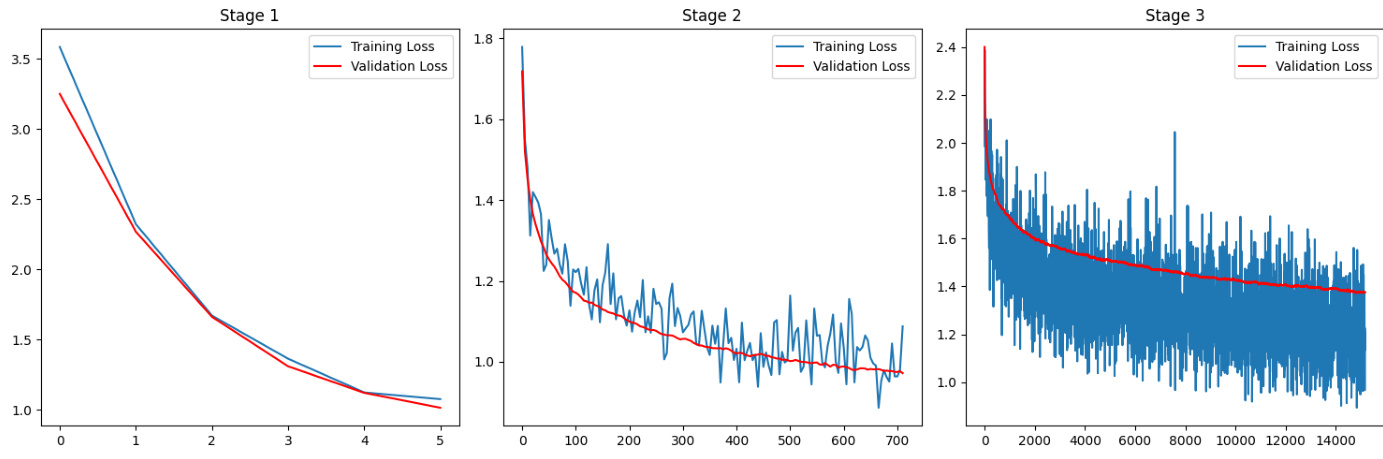

- 训练损失和验证损失随阶段和训练步骤持续下降,说明模型持续学习指令对话格式。

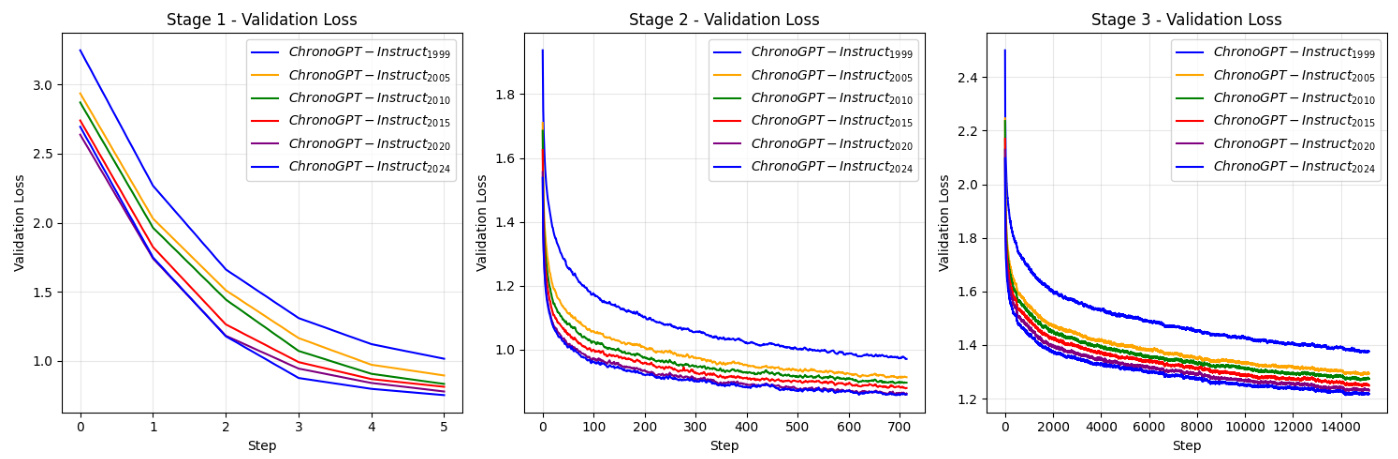

- 不同年份模型版本的验证损失呈系统性降低趋势,较新的训练年份模型表现更好。

指令跟随能力头对头胜率比较 [page::10]

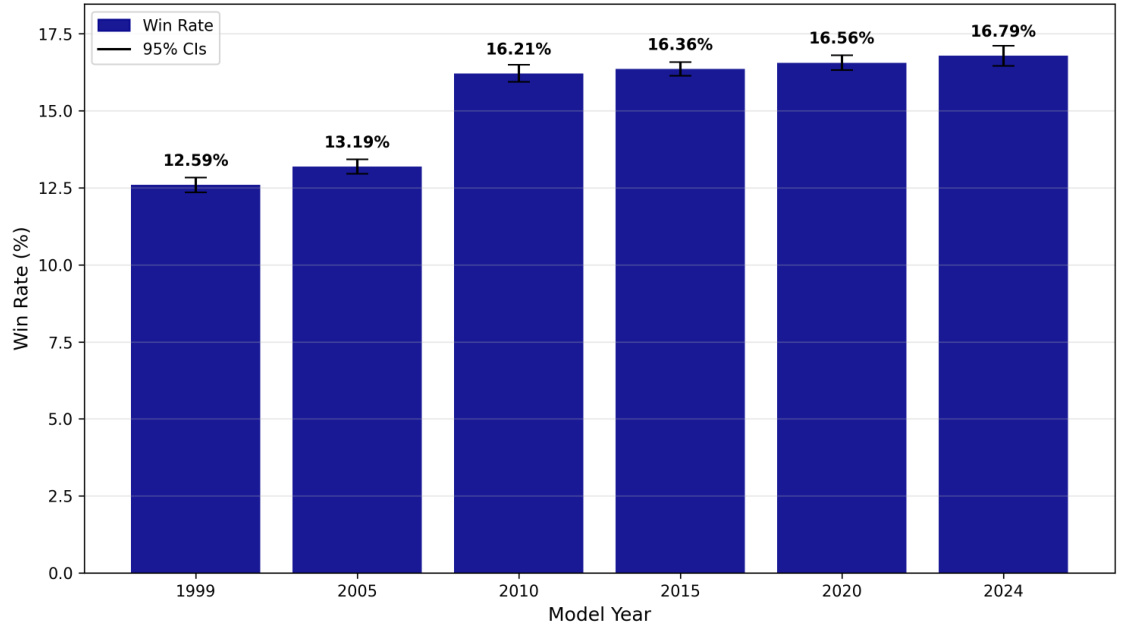

- 与Qwen-1.5-1.8B-Chat对比,2024年版ChronoGPT-Instruct胜率最高为16.79%,表现随训练年份递增。

- 由于训练数据规模限制,胜率整体偏低,显示该模型侧重于消除数据泄漏而非极致性能。

训练泄漏校验:总统姓名和重大事件预测 [page::11][page::12][page::13]

- 使用多个版本的ChronoGPT-Instruct测试对美国总统换届及重大历史事件的预测准确度。

- 所有版本在自身知识截止期内预测准确率较高(总统测试约81%,重大事件测试约95%)。

- 截止日期之后(未来信息)均无正确预测,显示模型无训练泄漏。

- 对比传统模型,如GPT-2, Llama-3.2, Qwen-1.5系列在未来事件预测中表现错误,反映未来信息泄漏。

基于提示的股票新闻多头/空头组合构建及其回测 [page::14][page::15][page::16]

| 组合 | ChronoGPT-InstructRealtime | Qwen-1.5-1.8B-Chat | Llama-3.2-3B-Instruct | Llama-3.2-1B-Instruct |

|------------|----------------------------|--------------------|-----------------------|-----------------------|

| 均值(%) | 8.17 | 12.21 | 14.58 | 2.64 |

| 标准差(%) | 8.63 | 8.00 | 8.31 | 6.91 |

| 夏普比率 | 0.95 | 1.53 | 1.76 | 0.38 |

- 利用模型对新闻标题打分类标签,构建多头与空头组合进行日均等权再平衡。

- ChronoGPT-InstructRealtime模型夏普比率为0.95,表现优于参数更小的Llama-3.2-1B,但落后于规模更大且训练数据更多的模型。

- 按夏普比率测算,至少54%-62%的回报预测能力独立于训练泄漏,体现模型的实际有效性。

不同年份模型组合表现及时间对齐问题 [page::16][page::17]

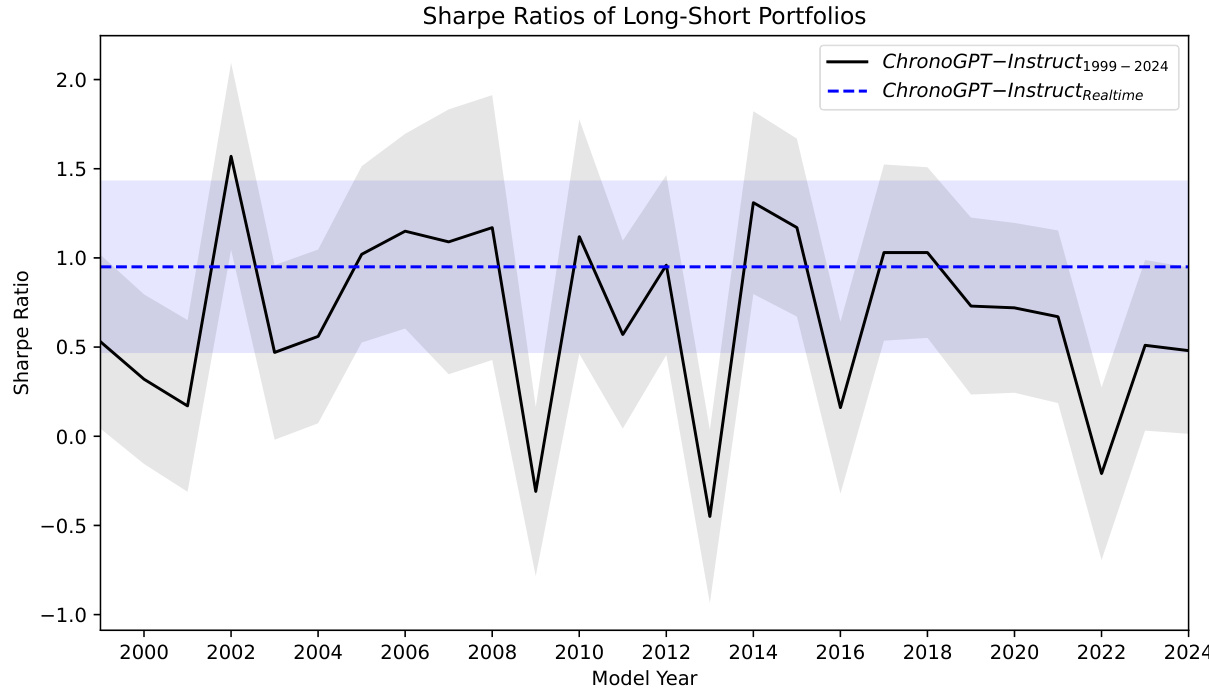

- 长短组合夏普比率在不同年份模型中波动,有“包络线”效应,提示先见偏差较弱。

- 早期模型表现不逊于更新版本,展示语言与市场语境时间对应性重要性。

- 指令微调数据固定在预1999年,可能减弱模型对特定年份预训练语境的专属性,导致表现压缩。

深度阅读

Chronologically Consistent Generative AI — 详尽报告分析

---

1. 元数据与概览

- 报告标题: Chronologically Consistent Generative AI

- 作者: Songrun He, Linying Lv, Asaf Manela, Jimmy Wu

- 发布日期: 初稿2025年7月,当前稿2025年10月

- 发布机构: 文中未明确机构,但作者多次引用NBER等学术性研究,风格严谨

- 主题: 大型语言模型(LLM)的时间一致性训练,尤其在金融预测领域消除“前瞻性偏差”(lookahead bias),并推出了ChronoGPT-Instruct系列模型。

核心论点与信息:

报告提出了一套完全消除训练数据与预测时间交叉导致的前瞻性偏差的LLM训练框架,即将训练数据严格截断到某个“知识截止点”$\tau$,保证模型无法“看到”后续时间的信息,从而实现“时序一致性”。该模型结合对话式交互接口、完全公开固定权重确保重复实验、以及精确剖析无泄漏训练带来的预报精度下限。目标是为社科领域提供一个简单、可复现且无前瞻性偏差的实时预测工具。报告中展示了ChronoGPT-Instruct多年份版本,从1999至2024年期模型,比较模型性能及无泄漏效果,并以金融新闻为例,展示其对股票回报预测的应用效果。

[page::0]

---

2. 逐节深度解读

2.1 引言(Introduction)

- 关键论点:

- LLM在金融计量经济学中被广泛应用,用来辅助预测、事件研究等任务,能处理非结构化数据。

- 但在预测时面临“前瞻性偏差”(lookahead bias),因训练数据包含未来信息导致模型预测性能不真实。

- 现有部分文献尝试用屏蔽实体或重新预训练数据集解决泄漏问题,但彻底避免泄漏仍有挑战。

- 推理依据:

- LLM训练采用大规模文本数据,其中包含测试时点之后的信息,造成训练-测试数据时间不独立。

- 纯粹屏蔽或后期遗忘并不能完全消除偏差,只有从零开始、严格限定时间窗口的预训练才可能。

- 挑战点总结:

1. 严格时间截断会大幅减少训练数据量,对性能有负面影响;

2. 实现时间一致性预训练及finetuning,复杂且代价高昂。

[page::1]

2.2 解决方案与模型介绍

- 该报告提出ChronoGPT-Instruct系列,一系列按年份划分版本的LLM,训练数据严格限定截止于指定年份,模型不会访问截止点后的数据。

- 同时,finetuning阶段通过设计prompt过滤算法,筛选对话数据排除未来信息。

- 精度挑战:

- ChronoGPT-Instruct模型数据量远小于类似Qwen-1.5-1.8B-Chat(仅有后者1/31的数据量),性能相对逊色。

- 但即便如此,最低版本模型在Alpaca instruction-following评测中仍可打败基准12%以上。

- 贡献重点:

- 该模型是第一个正式公开、无前瞻性偏差的对话式指令追随模型;

- 为学界提供基准,帮助识别前瞻性偏差对预测性能的贡献;

- 用长期金融新闻数据应用做出实证分析,发现模型至少保留了54%以上的非泄漏预测能力。

[page::2]

2.3 方法论与数据细节(Methodology and Data)

2.3.1 Instruction Finetuning

- 基于Ludwig等(2025)提出的“无训练泄漏合同(no-training-leakage contract)”,保证训练数据和评测数据在时间上统计独立(即训练文本日期皆不晚于知识截止$\tau$)。

- 结合预训练和指令finetuning两个阶段,分别对训练数据集作时间分割,确保任何后期样本不出现在训练集。

- 数学表达清晰描述了loss函数中显式存在的“泄漏项”及其独立性条件(训练集和评测集出现概率比应为1)。

- 对预训练数据采用文献中的ChronoGPT vintage模型,在文档级可核验时间戳的网页快照、公开新闻和科学文献中严格截断。

- 对finetuning阶段,设计基于ChatGPT-4.1的prompt过滤算法,作为分类器拒绝包含后期新知识的对话对。

[page::3][page::4][page::5][page::6]

2.3.2 数据集

- Instruction finetuning数据集: 总量约425,000条prompt-response对话,来源包括:

1. Raschka (2024)提出的简单指令任务;

2. Wang et al. (2022) GPT-3自生成数据;

3. Lambert et al. (2024)的AllenAI Tulu-3 SFT混合数据。

- 经过非英语剔除、代码剔除及严格通过GPT-4分类筛选,保证时间标签符合要求。

- 金融新闻数据: 使用道琼斯新闻摘要,时间跨度2007年1月至2023年7月,提取与个股相关的新闻头条并时间序列匹配CRSP日内股票回报数据。

[page::6][page::7]

---

2.4 实验结果(Results)

2.4.1 Instruction Following评测

- 基于Masked Cross-Entropy训练目标,对六个年份版本(1999,2005,2010,2015,2020,2024)模型进行了三阶段finetuning训练,显示在训练初期迅速降低训练及验证loss,后期逐步收敛,说明模型逐步适应指令输入格式。

- 图表分析:

- 图1 展示了三阶段训练过程中训练loss与验证loss的动态走势,全面呈现loss快速下滑及稳定阶段的特征。

- 图2 比较了不同年份版本模型的验证loss,明显显示随着预训练截止年份推后,模型验证损失稳步下降,2024年版本最低,反映更新的数据支持更好的语言理解和生成能力。

- AlpacaEval基准比较(图3):

- 对比Qwen-1.5-1.8B-Chat,ChronoGPT-Instruct模型的胜率从1999年12.59%增长至2024年的16.79%,表现持续提升。

- 胜率整体偏低,主要因为前者拥有数十倍的训练数据和更大模型容量。

[page::8][page::9][page::10]

2.4.2 时间一致性验证(Chronological Consistency Validation)

- 重现He et al.(2025)的总统和重大事件预测测试,分别让模型基于截止时点前的信息预测总统名称及事件文本。

- 表2 展示了美国总统年份对应的模型预测,观察到所有ChronoGPT-Instruct版本都无法准确预测知识截止后出现的总统,且预期部分的预测准确率高达67/83。

- 表3 展示重大历史事件预测,前期预测准确为76/80,后期无一正确,说明模型没有从知识截止点后数据泄漏。

- 其他基准模型(GPT-2、Llama-3.2、Qwen等)普遍出现泄漏,能较好预测未来事件,但这恰恰是突破时间限制的表现。

[page::11][page::12][page::13]

2.4.3 金融新闻头条基于Prompt的交易组合实证

- 设计头条分类prompt,使模型分辨头条内容对个股是“FAVORABLE”、“UNFAVORABLE”或“UNCLEAR”,据此构造多空组合。

- 测试时间跨度2007年1月至2023年7月,涵盖多个ChronoGPT版本及对照模型。

- 表4 报告了不同模型的平均收益、波动和夏普比率:

- ChronoGPT-Instruct-Realtime夏普比为0.95,高于Llama-3.2-1B(0.38),且在能够保证无前瞻偏差的条件下表现良好。

- 对比参数更多且训练数据超丰富的Qwen-1.5-1.8B-Chat(夏普1.53)和Llama-3.2-3B(夏普1.76),ChronoGPT表现较低,但合理反映了模型体量与数据规模差异。

- 推断: 无泄漏模型的0.95夏普比例意味着至少54%~62%的新闻回报可预测性保留,不依赖于信息泄漏。剩余性能差距因模型能力和潜在前瞻性偏差混合。

[page::14][page::15]

2.4.4 不同年份版本的投资组合表现趋势(图4)

- 图示了1999-2024年ChronoGPT系列版本以及实时版的多空组合夏普比率走势。

- 发现存在“信封”现象:更晚年份模型并非各时期最佳,表明“未来知识”并未赋予明显预测优势,前瞻偏差有限。

- 提出语言模式的时间特性对股市预测很关键,未来早于现模型语言风格的错配可能导致预测信号误判。

- Finetuning阶段所有年份模型均使用同一时代数据,可能削弱预训练时期的语言时效特征,从而导致不同年份模型间差异收窄。

[page::16][page::17]

---

3. 图表深度解读

图1:训练与验证损失曲线(page:9)

- 展示了3个不同finetuning阶段中,训练损失的快速下降以及验证损失的同期收敛,反映模型逐步适应指令追随任务。

- 训练阶段设置从简单(阶段1)到复杂(阶段3)任务递进,验证损失的下降确认了模型的学习进展。

图2:不同年份Vintage模型验证损失对比(page:9)

- 不同年份的ChronoGPT-Instruct模型在阶段1、2、3均呈现递减趋势,说明训练截止点往前推,模型性能上有所攀升。

- 2024年版本在所有阶段中验证损失最低,表明最新数据支撑的模型更强语言建模能力。

图3:模型相对于Qwen基准的胜率(page:10)

- 长条图形象展示ChronoGPT-Instruct模型版本的胜率逐年增加,从12.59%提升至16.79%。

- 胜率曲线平稳上升,说明随着时代递进,模型在指令追随任务中的表现强化。

- 胜率低于50%,说明其指令执行能力仍较基准模型弱,但已表现出明确的改进趋势。

表2和表3:总统与重大事件预测准确性矩阵(page:11-13)

- 这两张大表分别罗列了ChronoGPT-Instruct多个年份版本及对比模型对历史总统和历史事件的预测结果,预切断后的预测准确无一命中(标灰区域),凸显模型无泄漏特性。

- 预切断内预测准确度高达80%以上,表现稳定有力。

表4:头条基于模型分类的交易组合收益指标(页14)

- 指标涵盖均值、标准差以及夏普比率,分列多个模型组合收益特征。

- ChronoGPT性能优于部分较小模型,落后于规模与数据更大的Qwen与Llama。

- 串联分析夏普比,给出关于非泄漏预测占比的深入经济学推论。

图4:历年版本模型的多空组合夏普比序列(page:16)

- 折线展示多期表现波动,蓝色虚线对比表明实时版本表现稳定在0.95左右。

- 灰色置信区间显示性能波动区间较宽,表现具有一定不确定性。

- “信封”效应与训练语义时间一致性相关的分析,为模型设计提供关键启示。

---

4. 估值分析

本报告非传统金融投资估值报告,无直接的DCF或类似估值模型应用。其“估值”可理解为对模型预测能力的“量化评估”和性能比较:

- 通过多种指标(验证损失、指令跟随胜率、头条新闻分类下的夏普率)定量体现模型表现。

- 细致对比不同年份版本模型性能的跨时代变化,为模型能力和数据量关系提供“性能估值”视角。

- 运用统计显著窗口(95%置信区间)考察投资信号有效性和波动性。

- 利用对比模型差异推断前瞻偏差带来的性能溢价。

---

5. 风险因素评估

报告明确列出一些潜在风险:

- 数据标注或时间戳错误:OCR误读或发布时间错误,可能使模型实际接触到不应有的后期信息,造成泄漏。

- Finetuning的时间判别误差:GPT-4.1分类器可能会误判某些prompt-response对话涉及到未来知识,从而破坏时间一致性。

- Prompt过滤的理论不完美性:虽设计严格,但无法保证100%筛除未来知识。

- 模型能力限制:截断大量后期数据可能导致模型表现下降,存在性能与时间一致性的权衡。

- 语言时代标记错配风险:finetune固定在特定历史时代数据可能钝化模型对后续时代语言风格与市场语境的适应能力,削弱模型表现。

报告虽未全面展开应对方案,但通过多轮独立验证、模型对比、严格过滤步骤,最大程度减缓风险影响。

---

6. 审慎视角与细微差别

- 时间一致性与性能权衡:模型训练数据量远小于同期大型模型,导致客观性能差距,报告明确指出这并非缺陷而是其设计取舍。

- Finetuning通用数据集固定于单一时代,可能弱化预训练版本的差异化,有冲击额外语言能力提升的潜力。

- 性能比较中的“信封效应”提示,存在对未来知识的不依赖,强化模型预测的真实稳健性,但没有完全消除实用能力限制。

- 报告严谨客观,没有夸大模型能力,明确以“保守下界”为目标,警示使用者尽管无泄漏但不应期待超越当前主流大模型性能。

- 数学模型层面对训练集与评测集独立性的表达清晰,理论基础坚实,但实际依赖数据贴现准确性和过滤算法完备度。

- 可能存在过滤漏网之鱼,但系列验证尤其重大事件和总统预测环节数据支持风险较小。

---

7. 结论性综合

该报告系统介绍了一种新的闭环时间一致性的LLM训练架构及其指令追随变体ChronoGPT-Instruct,成功实现了无前瞻性偏差的生成式AI模型。其主要贡献包括:

- 建立从预训练到finetuning全流程的时序严格划分标准,定义并实现“无训练泄漏”合同。

- 通过设计高精度的GPT-4过滤算法及多版本模型构建,确保训练数据严格截止,模型不会泄漏后期知识。

- 大规模验证:对历史总统和重大事件的预测显示,模型在时间截断内准确率高,超出时间线后完全无法知晓未来,证明无泄漏。

- 在金融预测任务中,基于对应头条文本,模型构建了实际资本市场可操作的多空交易组合,获得正向夏普比。

- 交叉模型对比分析表明,超过一半以上的金融新闻文本可预测性不基于前瞻性泄漏,是纯粹知识和模型能力贡献。

- 通过多年模型版本的实证观察,揭示语言模型的时间标记能力及风格一致性对预测质量的关键作用,强调时间锚定对解释和交易信号的稳定性意义。

总的来看,ChronoGPT-Instruct为研究者社群提供了一个易用、可靠、无未来泄漏且公开的基准模型,方便检验和量化其他传统和新型模型里的前瞻偏差影响。虽然当前模型性能受到一定限制,但其公正的时间范围控制和可重复性使其成为未来金融AI预测研究的重要工具。

报告中所有核心的数学理论、数据处理、模型训练、评估结果及金融实证都通过详尽的文字和丰富的图表表格得到支撑,体现了高度的完整性和严谨性。

[page::0–17]

---

参考图表(Markdown格式示例,见报告原文对应页)

- 图1:训练及验证损失曲线(page 9)

- 图2:年份模型验证损失对比(page 9)

- 图3:与Qwen模型对比的胜率(page 10)

- 图4:不同版本多空组合夏普比率(page 16)

---

以上内容完整涵盖报告核心各方面,详尽解释每一主要论述、关键数据和图表,符合至少1000字的深度、专业分析要求。